Het hele verhaal van SB 1047 is lang en ingewikkeld, maar de essentie ervan is eigenlijk vrij simpel. Over het algemeen wil de kunstmatige-intelligentie-industrie niet gereguleerd worden. Het wil vooral niet aansprakelijk zijn voor schade veroorzaakt door zijn AI-modellen. Omdat SB 1047 de sector reguleert en aansprakelijkheid gebruikt om deze regelgeving af te dwingen, wil een groot deel van de industrie de wet niet.

Insiders uit de sector kunnen dit niet expliciet zeggen, dus komen ze met andere argumenten (vaak tegen versies van het wetsvoorstel die niet bestaan). Het is niet zo verwonderlijk dat deze argumenten de toetsing niet echt doorstaan.

SB 1047 verplichtte voornamelijk dat de grootste AI-ontwikkelaars veiligheidsmaatregelen implementeren om catastrofale risico’s te beperken. Als het AI-model van een gedekt bedrijf een ramp veroorzaakt, gedefinieerd als ‘massale slachtoffers’ of $500 miljoen of meer aan schade En de veiligheidsmaatregelen van het bedrijf waren niet in overeenstemming met de beste praktijken in de sector en/of de relevante overheidsnormen, Dan het bedrijf kan aansprakelijk zijn voor schade en aanvullende financiële boetes. Het wetsvoorstel omvatte ook bescherming voor AI-klokkenluiders.

Het zou de eerste wet in de Verenigde Staten zijn geweest die verplichtte dat deze bedrijven waarborgen implementeren om catastrofale risico’s te beperken, waarmee ze breken met de traditie van het gebruik van de vrijwillige AI-veiligheidsverplichtingen waar de industrie en nationale wetgevers de voorkeur aan geven.

OpenAI, Meta, Microsoft en Google waren tegen het wetsvoorstel van de Senaat van Californië en voerden aan dat AI-regelgeving in plaats daarvan op federaal niveau zou moeten plaatsvinden.

De Republikeinen hebben zich echter ertoe verbonden belangrijke nationale wetgeving te belemmeren en het uitvoerend bevel van Joe Biden inzake AI ongedaan te maken, wat het dichtst in de buurt komt van een nationale AI-regelgeving. Deze bedrijven hebben ook veel minder te vrezen van federale wetgevers, die in grotere mate in hun zak zitten. In augustus publiceerden acht Democraten uit het Huis van Afgevaardigden uit Californië een brief tegen het wetsvoorstel, die vol stond met discussiepunten uit de sector.

Voormalig voorzitter van het Huis van Afgevaardigden Nancy Pelosi volgde de congresbrief kort met haar eigen verklaring tegen het wetsvoorstel, in wat de eerste keer lijkt te zijn dat ze zich verzet tegen een stuk wetgeving op staatsniveau van een lid van haar eigen partij.

Pelosi’s financiële openbaarmaking uit 2023 meldt dat haar man tussen de $ 16 en $ 80 miljoen aan aandelen en opties bezit bij Google, Amazon, Microsoft en Nvidia. En Pelosi’s dochter Christine zal naar verwachting na haar pensionering het opnemen tegen de auteur van het wetsvoorstel, senator Scott Wiener, voor de zetel van de voormalige voorzitter in het Congres. Deze overtuiging heeft aanleiding gegeven tot speculaties dat ze Wiener probeert te beschadigen en Christine te verheffen.

Pelosi’s vreemde patroon van steunbetuigingen uit San Francisco is ook logischer als je beseft dat ze allemaal met Wiener hebben gevochten. Pelosi heeft Wiener duidelijk niet gesteund in zijn herverkiezingscampagne.

Zoals ik eerder besprak in de Natie, Tegenstanders van SB 1047 beweren dat er een “massale publieke verontwaardiging” bestaat tegen het wetsvoorstel en benadrukken de ingebeelde en niet-onderbouwde schade die sympathieke slachtoffers zoals academici en open-sourceontwikkelaars zal overkomen. Het wetsvoorstel is echter rechtstreeks gericht op de grootste AI-ontwikkelaars ter wereld en krijgt steun van de bevolking in de hele staat, met nog sterkere steun van technologiewerkers.

Deze fundamentele dynamiek bleef grotendeels hetzelfde, maar resulteerde uiteindelijk in een aantal vreemde bedgenoten: miljardair Elon Musk staat in de rij voor sociale rechtvaardigheidsgroepen en vakbonden om het wetsvoorstel te steunen, terwijl voormalig Huisvoorzitter Nancy Pelosi, progressief Huiscongreslid Ro Khanna, Trump-ondersteunende onderneming kapitalist Marc Andreessen en AI “meter” Fei-Fei Li zijn allemaal tegen.

Maar sinds de congresbrief en de oppositieverklaring van Pelosi in augustus lag het momentum vrijwel geheel bij de voorstanders van het wetsvoorstel.

Anthropic onderscheidde zich van andere toonaangevende AI-bedrijven door in een open brief te schrijven dat de “voordelen van het herziene wetsvoorstel waarschijnlijk groter zijn dan de kosten.” De brief volgde op een reeks wijzigingen die rechtstreeks waren aangebracht als reactie op de eerdere zorgen van het bedrijf.

SB 1047 werd met sterke meerderheden door beide kamers van de wetgevende macht van Californië aangenomen, en de peilingen bleven goed. Deze peilingen werden allemaal uitgevoerd door een non-profitorganisatie die pro-regulering was, maar het topresultaat veranderde niet toen de stembureau een tegenstander de oplichterij-argumenten liet opschrijven.

Meer dan 110 huidige en voormalige werknemers van de vijf grootste AI-bedrijven (die allemaal in Californië zijn gevestigd) publiceerden een brief waarin ze het wetsvoorstel steunden, met het argument dat “de krachtigste AI-modellen binnenkort ernstige risico’s met zich mee kunnen brengen, zoals uitgebreide toegang tot biologische producten.” wapens en cyberaanvallen op kritieke infrastructuur.”

Brieven waarin werd aangedrongen op de handtekening van Newsom werden ondertekend door SAG-AFTRA en Hollywood-sterren als Ava DuVernay, Jane Fonda, JJ Abrams, Shonda Rhimes, Alec Baldwin, Pedro Pascal, Jessica Chastain, Adam McKay en Ron Perlman.

In een laat stadium kwamen er steunbetuigingen van machtige groepen als ParentsTogether en de Californische afdeling van de AFL-CIO, die zich aansloten bij eerdere steun van groepen als de SEIU, de Latino Community Foundation en de National Organization for Women.

Deze uitgebreide coalitie was uiteindelijk niet genoeg om de bittere tegenstand van de technologie-industrie en machtige nationale democraten als Pelosi te overwinnen.

OpenAI, Meta en Google voerden allemaal aan dat het wetsvoorstel AI-bedrijven ertoe zou kunnen aanzetten Californië te verlaten. SB 1047 zou echter van toepassing zijn geweest op elk gedekt AI-bedrijf dat zaken doet in de staat, de op vier na grootste economie ter wereld en de thuisbasis van de vijf grootste generatieve AI-bedrijven. Anthropic CEO Dario Amodei deed dit idee af als ‘slechts theater’.

De machtigste bondgenoten van de industrie waren de nationale democraten, die zich tegen het wetsontwerp uitten. Maar ze kregen grote steun van ‘meter van AI’ en Stanford-professor Fei-Fei Li, die een opiniestuk publiceerde in Fortuin ten onrechte bewerend dat de “kill switch” van SB 1047 de open-source AI-gemeenschap effectief zou vernietigen. Li’s opiniestuk werd prominent geciteerd in de congresbrief en de verklaring van Pelosi, waarin de voormalige voorzitter zei dat Li “wordt gezien als Californië’s beste AI-academicus en -onderzoeker en een van de beste AI-denkers wereldwijd.”

Nergens binnen Fortuin of in deze congresverklaringen werd vermeld dat Li een AI-startup ter waarde van een miljard dollar had opgericht, gesteund door Andreessen Horowitz, het durffonds achter een lastercampagne tegen de verschroeide aarde.

Op dezelfde dag dat hij zijn veto uitsprak over SB 1047, kondigde Newsom een nieuwe raad van adviseurs op het gebied van AI-beheer voor de staat aan. Li is de eerste naam die genoemd wordt.

Newsom publiceerde een brief van drie pagina’s waarin hij zijn veto uitlegde, waarin hij een algemeen pro-reguleringsaanpak hanteert, terwijl hij argumenten naar voren brengt die ook niet tegen nauwkeurig onderzoek bestand zijn.

Hij schrijft bijvoorbeeld:

Door zich alleen te concentreren op de duurste en meest grootschalige modellen, creëert SB 1047 een regelgevingskader dat het publiek een vals gevoel van veiligheid zou kunnen geven over het beheersen van deze snel evoluerende technologie. Kleinere, gespecialiseerde modellen kunnen even gevaarlijk of zelfs gevaarlijker blijken te zijn dan de modellen waarop SB 1047 zich richt.

Met andere woorden: zowel grote als kleine AI-modellen kunnen riskant zijn – dus moeten we ook geen regelgeving opstellen?

De ontdekking die ten grondslag ligt aan de hele explosie van generatieve AI is bovendien dat de mogelijkheden van modellen meegroeien met de modelomvang. Er zijn risicovolle toepassingen van AI, zoals het gebruik ervan bij beslissingen over welzijn, aanwerving en voorwaardelijke vrijlating, die onder de loep moeten worden genomen, strikt moeten worden gereguleerd of volledig moeten worden verboden. Maar het risico dat een model het soort catastrofes veroorzaakt waarop SB 1047 zich richtte – zoals het mogelijk maken van een grootschalige cyberaanval of het helpen bij het creëren van nieuwe biowapens – is veel groter in systemen die groter en krachtiger zijn dan de huidige stand van de techniek. .

En als u denkt dat Newsom een uitgebreidere versie van het wetsvoorstel zou hebben ondertekend, die ook op kleinere modellen is gericht, heb ik u een brug te koop.

Later schrijft hij:

Laat ik duidelijk zijn – ik ben het met de auteur eens – we kunnen het ons niet veroorloven om te wachten tot er een grote catastrofe plaatsvindt voordat we actie ondernemen om het publiek te beschermen. Californië zal zijn verantwoordelijkheid niet opgeven. Er moeten veiligheidsprotocollen worden aangenomen. Er moeten proactieve vangrails worden geïmplementeerd, en de ernstige gevolgen voor slechte actoren moeten duidelijk en afdwingbaar zijn.

Laten mij wees duidelijk: het besluit van Newsom betekent dat er geen verplichte veiligheidsprotocollen zullen zijn voor de ontwikkeling van de grootste en krachtigste AI-modellen. De ruim tien AI-wetsvoorstellen die Newsom heeft ondertekend, behandelen dit niet, en geen van hen kreeg ook maar in de buurt te maken met de weerstand van de industrie die SB 1047 ontving.

In tegenstelling tot Newsom beweren de slimste critici van de wetgeving, zoals AI-journalist Timothy B. Lee, alleen maar dat het misschien voorbarig is, door te zeggen: “We moeten wachten tot er meer geavanceerde modellen bestaan, zodat we een beter idee hebben hoe we deze moeten reguleren.”

Dean W. Ball, een onderzoeker aan het libertair georiënteerde Mercatus Center van de George Mason Universiteit, vertelde me in een telefonisch interview: “Er bestaat een legitiem meningsverschil over de vraag of regulering op dit moment noodzakelijk is.” Het hele debat gaat volgens hem over de vraag of AI-systemen in de nabije toekomst in staat zullen zijn het soort rampen te veroorzaken dat het wetsvoorstel wil voorkomen. Ball denkt dat als “modelcapaciteiten zich ontwikkelen op de manier waarop zeker SB 1047-aanhangers lijken te denken dat ze dat zullen doen, de noodzaak van een dergelijke regulering duidelijker zal worden.”

Supporters zijn eerder bang dat ze te laat komen dan te vroeg. Bill-cosponsor Teri Olle, directeur van Economic Security California, zei in een telefonisch interview: ‘De laatste keer dat we dit soort momenten hadden, was met de sociale media’, maar ‘we knipperden met onze ogen en als gevolg daarvan proberen we nu nog steeds op te pikken de stukken.”

In de brief van het Congres werd beweerd:

Helaas is SB 1047 scheef in de richting van het aanpakken van extreme misbruikscenario’s en hypothetische existentiële risico’s, terwijl aantoonbare AI-risico’s zoals desinformatie, discriminatie, niet-consensuele deepfakes, gevolgen voor het milieu en ontheemding van personeel grotendeels worden genegeerd.

Newsom pakte een soortgelijke aanpak in zijn vetobrief en schreef:

Een aanpak die uitsluitend uit Californië bestaat kan gerechtvaardigd zijn – vooral als er geen federaal optreden van het Congres is – maar deze moet gebaseerd zijn op empirisch bewijs en wetenschap. Het Amerikaanse Al Safety Institute, onder het National Institute of Science and Technology, ontwikkelt richtlijnen over nationale veiligheidsrisico’s, gebaseerd op op bewijs gebaseerde benaderingen, om te waken tegen aantoonbare risico’s voor de openbare veiligheid.

Hij prijst andere inspanningen om AI-risico’s te beheersen ‘die geworteld zijn in wetenschap en feiten’, en de ruim tien wetsvoorstellen ‘die specifieke, bekende risico’s van Al reguleren’ die hij de afgelopen dertig dagen heeft ondertekend.

Tegenstanders van AI-veiligheidsregels willen dat je gelooft dat deze ten koste gaan van het reguleren van de bestaande schade van de technologie.

Maar zoals ik schreef Jacobijn in januari:

Het debat dat zich op het publieke vlak afspeelt, doet je misschien geloven dat we moeten kiezen tussen het aanpakken van de directe schade van AI en de inherent speculatieve existentiële risico’s ervan. En er zijn zeker afwegingen die een zorgvuldige afweging vereisen.

Maar als je kijkt naar de materiële krachten die een rol spelen, ontstaat er een ander beeld: aan de ene kant proberen miljardenbedrijven AI-modellen krachtiger en winstgevender te maken; in een andere zie je maatschappelijke organisaties die proberen AI waarden te laten weerspiegelen die routinematig botsen met winstmaximalisatie.

Kortom, het is kapitalisme versus menselijkheid.

Hoewel SB 1047 er niet in slaagde wet te worden, slaagde het er toch in dit beeld onder de aandacht te brengen. SB 1047 was het product van een lang, weloverwogen, democratisch proces.

Als reactie op aanvallen door AI-investeerders schreef Wiener in juli: “SB 1047 is het product van honderden gesprekken die mijn team en ik hebben gehad met een breed scala aan experts, waaronder zowel supporters als critici, en inclusief oprichters van startups, grote technologiebedrijven, academici, voorstanders van open source en anderen.”

Een Big Tech-lobbyist vertelde me dat Wiener “buitengewoon serieus is in de manier waarop hij dit benadert, zoals veel politici met wie ik te maken heb dat niet doen.”

Wiener organiseerde meerdere gemeentehuizen met tech-oprichters en wijzigde het wetsvoorstel aanzienlijk als reactie op hun feedback. Het wetsvoorstel kreeg consistente, sterke steun in de wetgevende macht en kreeg goede opiniepeilingen, waarbij de steun in de loop van de tijd toenam omdat de kerncomponenten ervan verduidelijkt.

Al dat werk werd teniet gedaan door de beslissing van één enkele man, wiens onsamenhangende bezwaren zijn werkelijke motivaties maskeren.

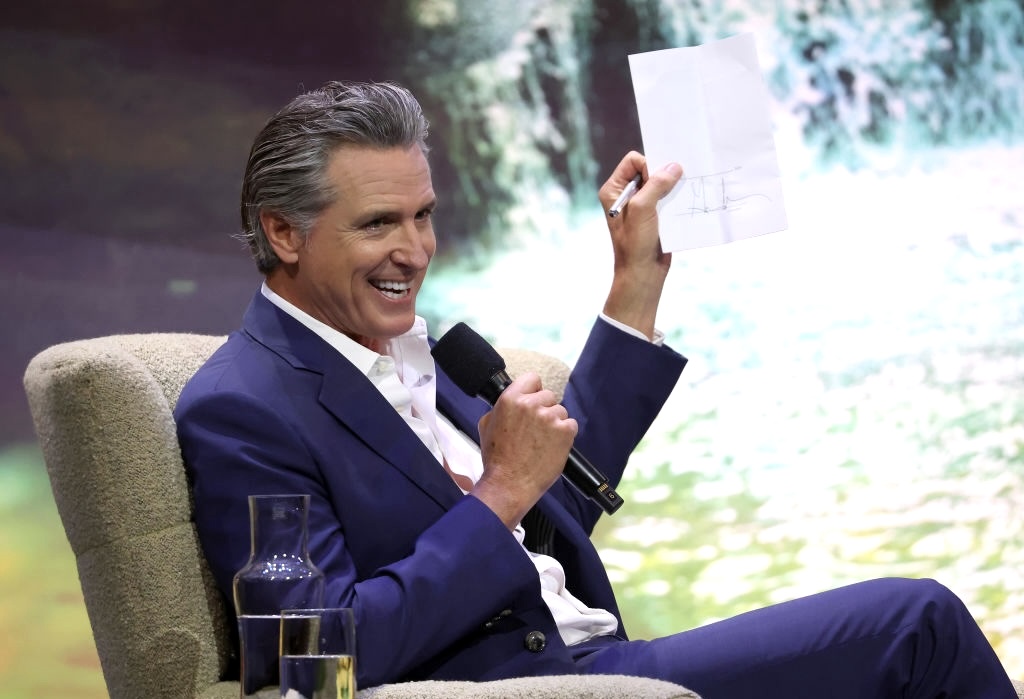

Maar in een andere zin was dit gewoon het zoveelste masker-off-moment voor Gavin Newsom, die Big Tech een enorme overwinning bezorgde, ten koste van de democratie en van iedereen die ooit schade zou kunnen ondervinden van AI-modellen die zijn gebouwd door bedrijven die opgesloten zitten in een een hevige race om het primaat en de winst.

Bron: jacobin.com